Sulle pagine di Nature un’interfaccia cervello-computer che potrebbe rivoluzionare il modo di esprimersi di chi non può. Prima legge l’attività del cervello per estrapolare una mappa dei movimenti del sistema vocale, e poi traduce questi in parole

In maniera del tutto spontanea, praticamente senza che ne abbiamo coscienza, quando parliamo muoviamo qualcosa come cento muscoli. Un intero sistema – dalla laringe, alla mascella, alla lingua alle labbra – si coordina per produrre i suoni che nascono nel cervello. Alcune malattie (come ictus o sclerosi laterale amiotrofica), possono compromette tutto questo, rendendo difficile se non impossibile a chi ne soffre parlare. E così esprimersi, comunicare, interagire. Esistono sistemi che in qualche misura permettono di recuperare queste abilità, sfruttando i movimenti della testa o degli occhi e interfacce cervello-computer per controllare un cursore, selezionare delle lettere e permettere così di esprimersi (cosiddetti spelling-based approaches). Ma si tratta di dispositivi lontani dal mimare il naturale flusso di un discorso. Oggi, sulle pagine di Nature, un team di ricercatori presenta i primi risultati relativi a un sistema che promette di ristabilire la capacità di parlare, in modo più fluente e naturale. L’idea arriva dal team di Edward Chang della University of California di San Francisco che è riuscito a mettere a punto un sintetizzatore vocale in grado di trasformare l’attività del cervello in parole e frasi.

I partecipanti allo studio hanno ripetuto decine di frasi ad alta voce mentre in contemporanea veniva registrata la loro attività cerebrale corrispondente, che è stata utilizzata per creare una rappresentazione dei movimenti del tratto vocale associati, grazie all’utilizzo di una rete neurale artificiale (e grazie alle informazioni provenienti da una libreria di dati simili collezionati in precedenza). Ed è stato dunque a partire dalla decodifica di questi movimenti, spiegano i ricercatori, che è stato possibile sintetizzare le frasi corrispondenti, trasformando in voce i segnali acustici estrapolati dalla lettura dell’attività cerebrale, in un processo appunto a due fasi. La caratteristica distintiva del loro decoder, puntualizzano infatti gli scienziati, è la rappresentazione articolare intermedia, che fa come da ponte tra l’attività neurale e quella acustica.

Non mancano certo tentativi e strategie per mettere insieme parole direttamente a partire dalla registrazione delle attività cerebrale (e persino le conversazioni interne), ricordano Chethan Pandarinath e Yahia Ali della Emory University e del Georgia Institute of Technology di Atlanta, in un commento al paper. L’approccio di Chang e colleghi a due fasi però, continuano i due, risponde alle osservazioni secondo cui “l’attività nelle aree del cervello collegate al parlare sono più legate ai movimenti dell’apparato vocale che ai segnali acustici prodotti mentre si parla”.

La rappresentazione acustica risultante dall’approccio di Chang e colleghi è stata abbastanza soddisfacente, come è possibile ascoltare. Tanto che alcuni se le frasi venivano fatte ascoltare ad alcuni volontari questi riuscivano a identificare e trascrivere quanto ascoltato.

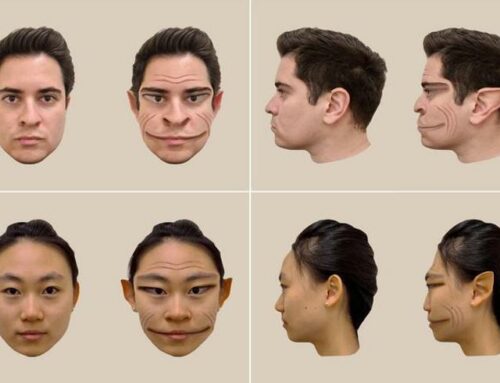

Uno dei limiti degli attuali sistemi, scrive il team di Chang sulle pagine di Nature, è rappresentato infatti dalla velocità. La maggior parte degli utenti infatti è ben lontana infatti dal raggiungere il tasso di 150 parole al minuto che caratterizza un normale discorso. L’alternativa proposta da Chang e colleghi mira proprio ad aumentare questo tasso. E lo fa attraverso un sistema capace di leggere nel cervello i segnali collegati al movimento della lingua, della lingua, delle labbra e della mascella. Un sistema a due fasi: in un primo momento l’attività cerebrale è usata per decodificare i movimenti che ci permettono di parlare, e successivamente questi vengono tradotti in pensieri e parole.

Per farlo gli scienziati hanno eseguito una serie di esperimenti, prima osservando poi cercando di mimare quanto osservato. Per leggere il cervello al lavoro nell’atto di produrre un discorso i ricercatori hanno monitorato l’attività cerebrale grazie a degli elettrodi impiantati nel cervello di cinque persone, come parte di un trattamento contro l’epilessia.

Ma gli scienziati sono andati oltre: hanno testato il loro decoder anche in assenza di segnali sonori, ovvero in presenza solo di frasi mimate, senza che venissero emessi suoni, ma accompagnate da tutti i movimenti muscolari necessari per formularle. E, sebbene la qualità delle frasi sintetizzate in questo caso fosse inferiore a quella di frasi pronunciate ad alta voce, il decoder è capace anche di funzionare sulla sola base dei movimenti articolari, in assenza di frasi udibili.

“La sintesi vocale diretta ha diversi vantaggi rispetto ai sistemi spelling-based”, scrivono i ricercatori. Oltre ad aumentare il tasso verbale, avvicinandolo a quello di una conversazione naturale, il sistema da loro ideato permette anche di veicolare informazioni che si perderebbero altrimenti, come l’intonazione, senza considerare che non è richiesto alcuno sforzo cognitivo o addestramento per poterlo utilizzare. “Per le persone in cui l’elaborazione corticale dei movimenti articolari è ancora intatta”, precisano in proposito gli scienziati, “un decoder basato su un’interfaccia cervello-computer potrebbe essere molto più intuitivo e semplice da acquisire”.

Tuttavia il grado di comprensione del decoder messo a punto dal tema di Chang è ancora lontano dall’essere paragonato a quello di una parlata comune, e dunque da una reale applicazione clinica. La replica degli esperimenti con più partecipanti, l’uso di sistemi per monitorare l’attività cerebrale in maniera più dettagliata, sono solo alcuni degli ingredienti necessari prima di pensare a un’interfaccia cervello-computer pronta per lo sbarco in clinica, concludono Pandarinath e Ali.

FONTE